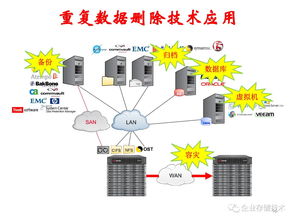

高效能重复数据删除存储技术 重塑数据处理与存储服务的新范式

随着数据量的爆炸式增长,企业数据中心和云服务提供商正面临着存储成本攀升、管理复杂度加剧以及能源消耗增大的严峻挑战。在此背景下,高效能重复数据删除存储技术应运而生,并逐渐成为优化数据处理与存储服务的核心驱动力。它不仅显著提升了存储空间的利用率,更在数据备份、归档、灾难恢复以及云存储等多个场景中展现出革命性的价值。

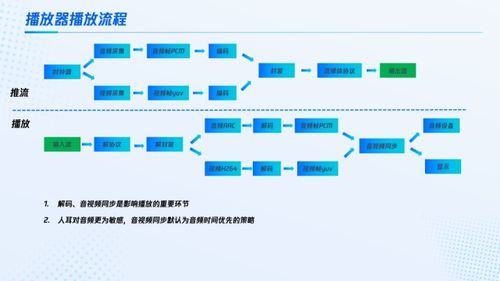

重复数据删除技术,其核心原理在于通过识别并消除数据集中的冗余副本,仅为唯一的数据块或文件保存一个实例,并辅以指针引用。高效能的实现,则依赖于算法优化、硬件加速以及智能策略的深度融合。现代系统通常采用在线或后处理去重模式,并结合可变长度分块、固定长度分块或全局重复数据删除等先进方法,以在性能与去重率之间取得最佳平衡。例如,利用内容寻址存储和指纹比对技术,可以在数据写入过程中实时识别重复内容,极大减少了存储空间的占用和后续传输的带宽需求。

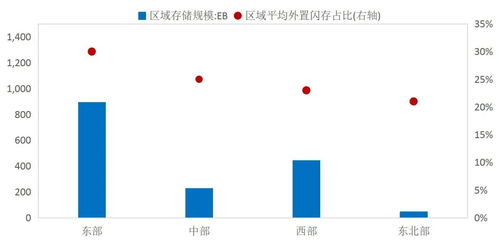

在数据处理和存储服务领域,这项技术的应用带来了多维度的根本性变革。它直接降低了存储硬件采购和运维的总拥有成本。通过高达10:1甚至更高的数据缩减率,企业可以用更少的物理磁盘存储更多的数据,从而节省机房空间、电力及冷却成本。它极大地提升了数据备份与恢复的效率。备份窗口大幅缩短,网络传输负载减轻,使得更频繁的备份策略成为可能,增强了数据保护级别。在灾难恢复场景中,只需传输和存储唯一数据变化,加快了恢复时间目标。

更重要的是,高效能重复数据删除技术与现代存储架构(如软件定义存储、超融合基础架构)及云服务深度集成,催生了更灵活、经济的数据管理服务。云服务提供商能够以更低的成本提供海量存储资源,用户则享受到更具性价比的存储即服务、备份即服务。它还为大数据分析、人工智能训练等需要处理海量原始数据的场景提供了支持,通过减少存储冗余,加速了数据在计算节点间的流动和处理速度。

实现真正的高效能并非没有挑战。计算资源的消耗、对随机读写性能的潜在影响以及数据安全性考量(如加密数据的去重)都是需要持续攻克的技术难点。未来的发展趋势将聚焦于与计算存储一体化、智能分层存储以及量子计算安全加密的更紧密协同,通过人工智能预测数据访问模式以动态调整去重策略,实现性能与效率的极致优化。

高效能重复数据删除存储技术已从一项提升存储效率的辅助功能,演进为支撑现代数据处理与存储服务体系的基石技术。它通过深度优化数据本身,而非单纯扩充硬件,引领着行业向更智能、更绿色、更经济的方向持续演进。对于任何依赖数据驱动的组织而言,理解和采纳这项技术,将是构建未来竞争优势的关键一步。

如若转载,请注明出处:http://www.xinyuan-technology.com/product/35.html

更新时间:2026-02-24 00:37:54